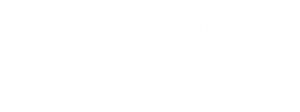

Niveles de riesgo en la "Ley de Inteligencia Artificial de la Unión Europea"

La Ley de Inteligencia Artificial de la Unión Europea, aprobada en junio de 2023 y con entrada en vigor prevista para 2024, establece un marco regulatorio pionero a nivel mundial para el desarrollo y uso de tecnologías de IA. Esta legislación es fundamental para garantizar que la IA se implemente de manera ética, segura y respetuosa con los derechos fundamentales de los ciudadanos. Para ello, clasifica las aplicaciones de inteligencia artificial en cuatro niveles de riesgo (inaceptable, alto, limitado y bajo), cada uno con diferentes requisitos y restricciones según su impacto potencial. A continuación, se explican estos niveles y su aplicación en el entorno educativo, junto con los artículos correspondientes de la ley.

El nivel de riesgo inaceptable, descrito en el Artículo 5, abarca sistemas de IA que se consideran peligrosos para la seguridad, los derechos fundamentales o los valores éticos, por lo que están prohibidos.

En el ámbito educativo, esto incluye, por ejemplo, sistemas que manipulan el comportamiento de los estudiantes de forma subliminal para influir en sus decisiones académicas, tecnologías que aplican vigilancia biométrica en tiempo real en entornos escolares sin consentimiento, y herramientas que discriminan automáticamente a ciertos grupos de estudiantes en función de datos sensibles.

El nivel de riesgo alto, regulado por el Artículo 6, se aplica a sistemas que impactan significativamente en los derechos fundamentales y la seguridad de las personas, por lo que están sujetos a controles estrictos.

En educación, ejemplos de este nivel incluyen sistemas de IA utilizados en evaluaciones de alto impacto, como exámenes de ingreso, donde un error puede afectar gravemente el futuro académico de los estudiantes; herramientas de selección automatizada para la admisión a programas específicos; y sistemas de monitoreo de conducta, en los que sesgos o errores podrían llevar a sanciones injustas.

El nivel de riesgo limitado, mencionado en el Artículo 8, incluye aplicaciones de IA que presentan riesgos menores y requieren transparencia.

En el contexto educativo, esto podría incluir el uso de chatbots que respondan preguntas sobre el contenido del curso, asistentes virtuales que sugieren materiales de estudio en función del rendimiento del estudiante, o sistemas que ofrecen retroalimentación automática en ensayos y tareas, siempre informando a los usuarios que interactúan con una IA.

Por último, el nivel de riesgo mínimo o bajo, que corresponde al Artículo 9, incluye aplicaciones de IA que prácticamente no presentan riesgos para los derechos o la seguridad, y no están sujetas a restricciones.

Ejemplos en el ámbito educativo incluyen sistemas que personalizan interfaces de aprendizaje para mejorar la experiencia del usuario, aplicaciones de recomendaciones de libros o artículos basadas en intereses previos, y correctores gramaticales que ayudan a mejorar la escritura de los estudiantes sin intervenir en la evaluación final.

Estos artículos dentro de la Ley de IA establecen un marco claro y proporcionado para el uso de la inteligencia artificial, asegurando que se apliquen medidas de control adecuadas según el impacto potencial de cada aplicación en sectores como el educativo.